在AI浪潮汹涌的今天,选择一款高效、稳定的LLM API至关重要。本文将深入介绍LLM API Test,一款开源Web工具,助您轻松对比GPT-4、Gemini等主流大模型的API性能。通过实时监测首令牌延迟、输出速度与成功率,开发者与研究人员能迅速掌握各模型的真实表现,为AI应用优化和采购决策提供数据支撑。

揭秘LLM API Test:您的AI性能测试专家

LLM API Test是一款功能强大的MIT开源Web工具,专为测试和比较大型语言模型API性能而设计。它能够实时记录关键指标,如首令牌延迟、每秒Token输出速度以及API调用成功率。这使得开发者和研究人员能够迅速评估并对比GPT-4、Gemini等主流大模型的API速度、稳定性和成本效益。

该平台支持7种语言,可进行静态托管部署,并内置了实用的质量比对与历史记录功能。无论是进行供应商评估、优化现有应用,还是开展学术研究,LLM API Test都是您不可或缺的工具。它能帮助您深入分析GPT-4 Turbo与Gemini Pro在速度、成本与质量上的差异,从而辅助做出明智的采购决策。

TechRadar 2025指南明确指出,开发者必须在吞吐量、模型质量与价格之间找到最佳平衡点。性能测试作为前期工作的重中之重,其重要性不言而喻。LangChain团队发布的基准环境,强调工具调用与函数执行能力的评估,可以与LLM API Test形成互补验证,提供更全面的性能洞察。

核心功能一览:全面评估LLM API

LLM API Test提供了一系列全面的功能,确保您能够对大模型API进行深入、细致的评估。

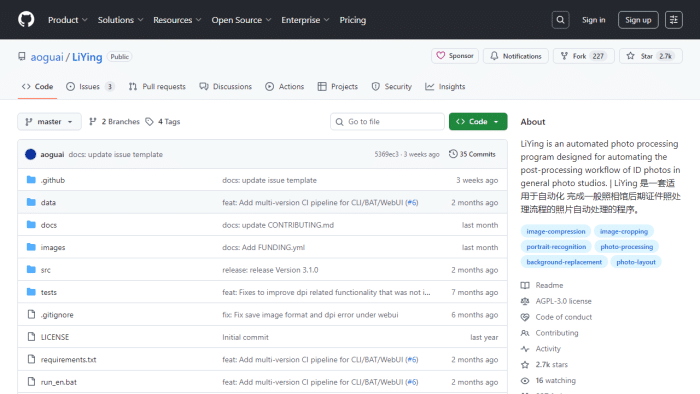

LLM API Test内置适配了OpenAI的GPT-3.5、GPT-4系列以及Google的Gemini Pro和Gemini Pro Vision协议。更重要的是,它还支持接入任何兼容OpenAI协议的自定义端点,极大地扩展了测试范围和灵活性,满足了多样化的模型测试需求。

- 首令牌延迟: 精确衡量首次响应时间,这是用户体验的关键指标。毫秒级的响应速度已成为生成式AI体验的核心。

- 输出速度: 以每秒Token数统计吞吐量,直观反映API的处理能力。这对于高并发、大数据量的AI应用至关重要。

- 成功率: 跟踪API调用的可靠性,确保您的应用能够稳定运行。高成功率是任何生产环境API的基础。

- 质量评估: 对比多模型响应内容,帮助您从语义和实用性角度评估模型的输出质量。这在内容生成、智能客服等场景尤为重要。

平台提供了响应式界面,完美兼容桌面与移动浏览器。实时图表能够随测试进度动态更新,让您对测试结果一目了然。历史记录功能则能持久化保存测试数据,便于您长期跟踪模型迭代和性能变化,为持续优化提供数据依据。

本地开发仅需Node.js和简单的HTTP服务器即可启动。同时,LLM API Test支持Vercel、Netlify、GitHub Pages等多种静态托管服务,也提供了一行Dockerfile,方便快速部署到容器环境,极大地简化了部署流程。

为什么性能基准测试不可或缺?

随着GPT-4.1 nano等低延迟商用模型的发布,毫秒级响应已成为衡量生成式AI体验的关键指标。社区排行榜如lmspeed.net实时展示各地API延迟,提醒开发者关注网络路径与供应商基础设施。NVIDIA、MLCommons等机构相继推出GenAI-Perf、MLPerf Client 1.0等工具,旨在标准化LLM负载与指标。这些都表明,一个统一、高效的性能测试工具对于AI开发者和研究人员而言,其价值日益凸显。

LLM API Test典型应用场景:赋能您的AI之旅

LLM API Test在多个场景中展现出其独特的价值,帮助用户做出数据驱动的决策。

供应商选型与采购决策

在众多大模型供应商中进行选择时,LLM API Test能提供客观的数据支持。通过对比不同供应商API的速度、可靠性和成本表现,您可以为您的项目选择最合适的合作伙伴,避免盲目决策。

成本-性能优化

理解不同模型的性能与成本之间的权衡至关重要。LLM API Test帮助您找到最佳的成本-性能平衡点,确保在预算范围内实现最佳的AI应用效果。

研究与学术论文

对于AI领域的研究人员而言,LLM API Test是进行模型比较、性能分析和验证假设的理想工具。其详细的指标和历史记录功能,为学术研究提供了坚实的数据基础。

快速上手LLM API Test:三步轻松开启

1. 启动测试环境

首先,您需要克隆LLM API Test的仓库并安装依赖。在命令行中执行npm install,然后运行npm start。之后,在浏览器中访问http://localhost:8000,即可打开测试界面。

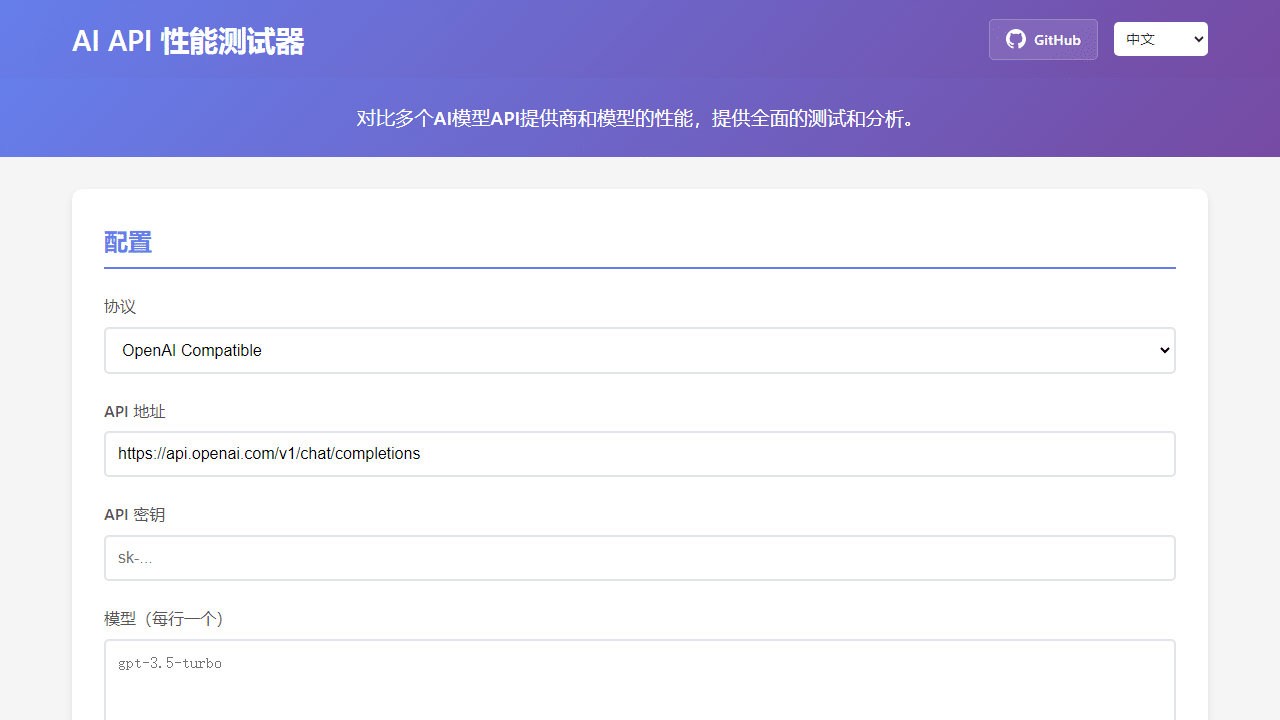

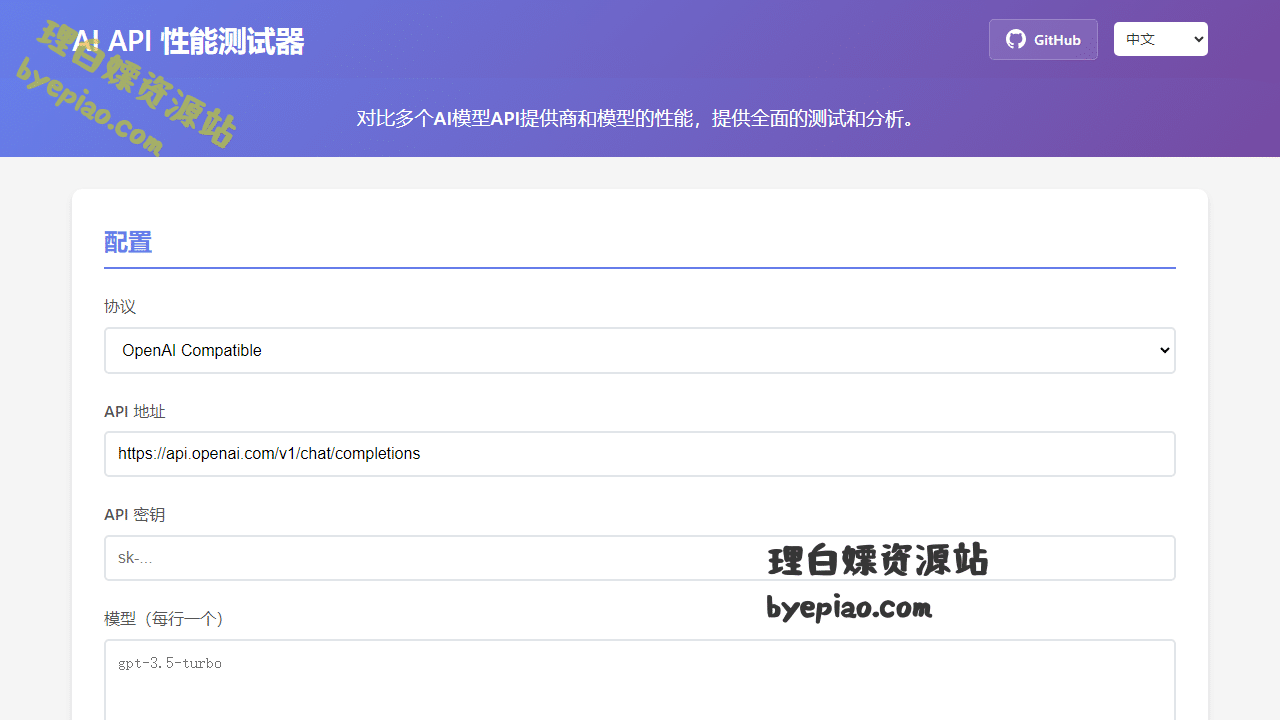

2. 配置您的API

在配置面板中,选择您要测试的API协议,填入API URL和密钥。根据需要,列出您希望测试的模型名称。LLM API Test将自动识别并准备测试环境。

3. 开始性能测试

设置您希望进行的测试轮次、并发度以及自定义的提示词。点击“Start Test”按钮,即可实时查看各项性能指标。所有数据将以图表形式直观呈现,助您快速洞察模型表现。

立即访问LLM API Test,开启您的LLM API性能优化之旅!通过这款强大的工具,您将能够更明智地选择和优化大模型API,为您的AI应用注入强劲动力,实现卓越的性能与用户体验。

本文由 理白嫖资源站 原创发布