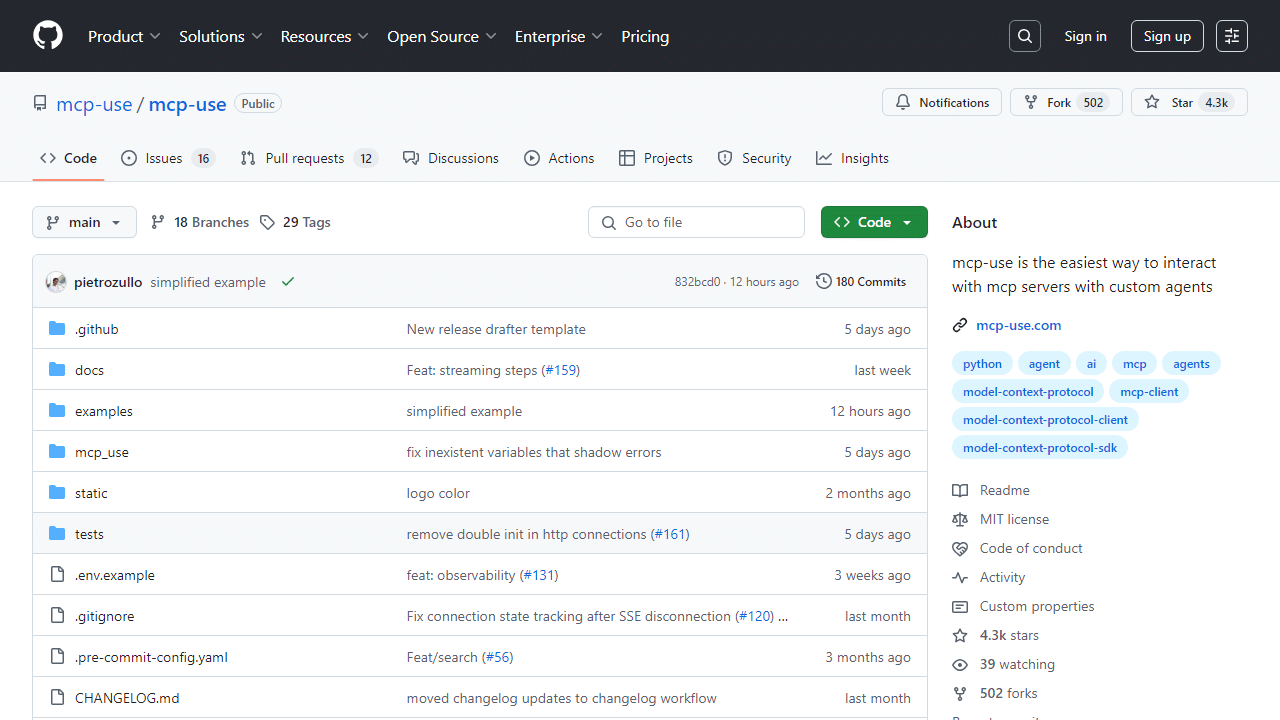

大型语言模型(LLM)的未来在于其工具集成能力。MCPUse是一款革新性开源客户端库,旨在弥合LLM与MCP服务器的鸿沟。它使支持工具调用的LLM,能无缝集成网页浏览、文件操作等功能,构建强大智能AI代理。

突破LLM能力边界:MCPUse如何革新AI工具集成

传统LLM擅长文本,但缺乏与外部系统交互能力,限制了应用前景。这阻碍了LLM在现实世界任务中的广泛应用。

模型上下文协议(MCP)作为开放标准,旨在为LLM提供统一工具和数据源接口,实现与外部应用的无缝连接。

MCPUse作为关键开源客户端库,正是这一愿景的实践者。它通过自定义代理机制,让支持工具调用的LLM连接到任何MCP服务器。

这意味着,OpenAI、Anthropic、Groq、LLaMA等模型,只要具备工具调用能力,均能通过MCPUse获得强大外部功能。

用户可轻松构建具备网页浏览、文件操作等能力的智能代理,极大拓展LLM应用场景和潜力。

MCPUse核心优势与创新特性深度解析

MCPUse不仅解决了LLM工具集成问题,更通过独特设计提供了多项显著优势,全面提升开发效率和代理性能。

极简集成,高效开发体验

该库操作简便,仅需六行代码,开发者便能创建首个具备MCP能力的智能代理,大幅缩短开发周期。

它支持通过HTTP端口直接连接正在运行的MCP服务器,满足Web环境异构部署需求,确保灵活高效的系统集成。

这种极简的集成方式,使得即使是初学者也能快速上手,将先进工具调用能力赋予自己的LLM应用,加速创新。

动态服务选择与多服务器协同

MCPUse内置智能动态服务选择功能。代理能根据当前任务需求,从预先配置的MCP服务器池中自动挑选最适合的服务。

单个代理实例能够同时使用多个MCP服务器,这为构建复杂的工作流提供了可能,实现前所未有的灵活性。

例如,一个智能代理可以同时结合网页浏览功能与3D建模能力,根据具体任务需求进行灵活调度。

这种协同工作模式,显著增强了AI代理在处理复杂、多领域任务时的适应性和效率。

强大的工具访问控制与安全保障

安全性是智能代理应用中不可忽视的一环。MCPUse提供精细化的工具访问控制功能,确保系统安全。

开发者可根据需要,轻松禁用文件系统访问或网络操作等潜在高危工具。这有效提升了AI代理的整体安全性和可控性。

通过限制特定工具的使用,可以有效防范未经授权的操作或数据泄露风险,确保智能代理在受控环境中运行。

这种安全机制为企业级应用提供了坚实的基础,使得LLM工具集成在保障数据隐私和系统安全的前提下进行。

广泛兼容性与LangChain生态整合

MCPUse通过与LangChain的深度整合,实现了与各种主流LLM提供程序的广泛兼容性,极大扩展了适用范围。

要使用MCPUse,您需要根据所选的LLM安装相应的LangChain提供程序包,并将API密钥添加到您的.env文件中。

重要提示:只有具备工具调用或函数调用功能的LLM模型,才能与MCPUse完美配合。请务必在选择模型时予以确认。

这项兼容性确保了开发者能够利用自己偏好的LLM,结合MCPUse的强大功能,快速构建出高性能的智能代理。

开启智能代理新篇章:立即体验MCPUse

MCPUse凭借其创新设计、强大功能和便捷开发体验,正在重新定义大型语言模型与外部工具的集成方式。

它为构建更智能、更实用、更安全的AI代理提供了坚实基础,开启了LLM应用的新纪元。

无论您是AI开发者、研究人员,还是对LLM应用充满好奇的探索者,MCPUse都值得您的深入了解和尝试。

立即行动,探索MCPUse的无限潜力吧!让您的LLM拥有与世界互动的能力,共同塑造AI的未来。